Gościem warszawskiego festiwalu Kultura 2.0 był Rui Guerra – promotor otwartej kultury, wykładowca Królewskiej Akademii Sztuk Pięknych w Hadze i współzałożyciel grupy INTK gromadzącej artystów, programistów i designerów. Podczas festiwalu porozmawialiśmy o tym, że powoli przestajemy dzielić odbiorców na tych wirtualnych i realnych – mówimy raczej o gościach online oraz on-site.

*

Pamiętasz swoje pierwsze zetknięcie z internetem?

Rui Guerra: Gdy miałem 12 lat, razem z sąsiadem połączyliśmy nasze komputery kablem szeregowym i tak po raz pierwszy zafunkcjonowałem w jakiejkolwiek sieci.

W celu?

Chodziło oczywiście o gry wideo. Później kupiłem modem i zacząłem wydzwaniać serwery danych. Wreszcie około połowy lat 90., z charakterystycznym dla nas poślizgiem, do Portugalii dotarł właściwy internet. Korzystałem głównie z grup Usenetowych. Chociaż pamiętam też kupowanie magazynów papierowych tylko po to, by szukać w niej adresów internetowych.

Były wtedy dobrem rzadkim, spisywało się je nawet z opakowań napojów czy musztard. Pamiętasz emocje z tamtego czasu?

Mieszkałem na opóźnionej gospodarczo i technologicznie prowincji, dlatego internet wydawał mi się oknem na świat. Pomagał zapomnieć, że żyję na peryferiach. Trochę jak MTV kilka lat wcześniej. Jednocześnie panowała w nim atmosfera undergroundu. Miałem wrażenie, że biorę udział w jakimś undergroundowym przedsięwzięciu, w niedostępnym przeciętnym ludziom, wyłączonym poza mainstream obiegu. Pamiętam wprawdzie artykuły z magazynu „Wired”, gdzie mówiło się już o autostradzie informacyjnej. Tyle że u nas nie było żadnej autostrady. Nie dość że powolny, internet wymagał kosztownego połączenia zagranicznego. Ściągało się potrzebne pliki i natychmiast odłączało kabel. Liczyła się każda sekunda.

Pytam o te początki, bo wielu wczesnych surferów rozczarowało się potem rozwojem sieci, chociażby wchłonięciem przez wspomniany mainstream.

A ja miałem przeciwnie. Internet zafascynował mnie do tego stopnia, że porzuciłem dla niego studia doktoranckie. Miałem zajmować się teorią programowania. Ale wyraźnie widziałem, że życie przenosi się do sieci. Coraz ważniejsze rzeczy wydarzały się online. Ślęczenie w uniwersyteckiej pracowni nad raportem dotyczącym języków programowania nagle okazało się wykluczać mnie z uczestnictwa w tym fascynującym procesie. Chciałem wrócić do sieci.

Kiedy to było?

Około 2005 roku. W Europie furorę robił wówczas Flickr. Facebook jeszcze nie istniał, przynajmniej w powszechnej świadomości.

A YouTube stawiało pierwsze kroki. Wkrótce jednak internet podzieliło między siebie kilka korporacji, które zarabiają na handlu naszym prywatnym życiem. Pionierzy sprzed dwóch dekad marzyli o czymś zupełnie innym.

Z drugiej strony technologia dogoniła ich prognozy i rzeczywiście poruszamy się obecnie po autostradzie informacyjnej. To prawda, że całymi połaciami internetu rządzą monopole. Każdy może jednak w każdej chwili stworzyć własną sieć lokalną, który będzie niezależna od globalnej. I poprzez którą będziesz mógł dzielić się dowolnymi zasobami. Wystarczy kupić laptopa.

Popularność Facebooka czy YouTube zdaje się świadczyć o tym, że zależy nam na czymś zgoła przeciwnym: udostępnianiu możliwie globalnym.

Tyle że wspomniane serwisy stosują określone standardy udostępniania informacji. Nie każdemu muszą się one podobać. Korzystam z Facebooka i Twittera, doradzam także instytucjom kultury, jak się w nich odnaleźć. Mam jednak z nimi pewien zasadniczy problem: sieci te sprzedają ci poczucie kontroli, którego wcale nie posiadasz. Wydaje ci się, że twoja sieciowa publiczność jest faktycznie twoja, że twój profil należy do ciebie, podobnie jak publikowane przez ciebie treści. A to nieprawda. W momencie, gdy załadujesz film na YouTube, tracisz kontrolę nad tym, jak i komu będzie on pokazywany. Kontroli tej nie sprawują dziś producenci treści, lecz właściciele technologii udostępniania.

Ponadto w sieciach tych bardzo łatwo polubić coś, co publikują inni, trudno jednak czegoś aktywnie nie lubić. To ogranicza przestrzeń dla krytyki. Dusi wszelkie konflikty. A konflikt stanowi jeden z fundamentów społeczeństwa. Kolejny powód to jakość usług, które oferują tudzież zamierzają oferować dostawcy internetu. Sporo mówi się teraz o selektywnym regulowaniu prędkości transferu w zależności od tego, jak często korzystamy z danych usług. Miłośnik YouTube otrzyma zatem szerokopasmowe połączenie z zasobami tego serwisu

Za to ograniczy mu się dostęp chociażby do protokołu peer-to-peer?

A w praktyce twój dostawca mógłby preferować te platformy, które podzielą się z nim zyskiem. I to wystarczający powód, by powrócić do podziemia. Poza tym dostęp do internetu kosztuje mnóstwo pieniędzy. Sam wydaję na ten cel 50 euro miesięcznie. A to przecież opłata za przysłowiową ostatnią milę. Gros infrastruktury należy wszak do państwa. Tymczasem przy obecnej technologii wi-fi wystarczyłoby, aby każdy z nas otworzył swoją prywatną sieć i pokrylibyśmy większość obszarów zamieszkałych przez człowieka. Wolałbym inwestować te moje 50 euro w coś pożyteczniejszego. Niech trafią do producentów treści i artystów, raczej niż ludzi, którym zawdzięczam głównie ból głowy.

Aby promować takie prywatne sieci, zainicjowałeś projekt unCloud.

Który jest reakcją na coraz powszechniejsze korzystanie z cloud computing, z tzw. chmury. Wielkie korporacje zachęcają nas, by przekazać im wszystkie nasze zasoby i pozwolić im się o nie zatroszczyć. Pomysł ten uwalnia nas od potrzeby posiadania twardego dysku. Wszystkie dane możemy trzymać w chmurze i w chmurze nad nimi pracować. Zmierzamy zatem do sytuacji, gdy miejsce komputera zastąpi rodzaj terminalu. Utracimy tym samym bezpośredni dostęp do mocy obliczeniowych. Aby dokonać jakiejkolwiek operacji, będziesz musiał skorzystać z zewnętrznego serwera. Pamiętasz początki informatyki, kiedy mocą obliczeniową dysponowały tylko komputery typu mainframe?

Trzeba ją było wynajmować na godziny.

Dlatego programiści pracowali nocami, gdy opłata była niższa, bo za dnia z komputerów korzystali pracownicy uniwersytetów. Wracamy do tego punktu. Rezygnujemy z „komputerów osobistych”. I to w momencie, gdy laptopy niczym specjalnym nie różnią się od serwerów, gdy każdy może mieć własny serwer i tworzyć własne sieci wirtualne. O tym przypominamy w ramach unCloud. Ale za dziesięć lat może to być już niemożliwe. Dysponując tylko ekranami-przeglądarkami, skażemy się na pozycję internetowych petentów. Tyle że ten pomysł jest na dłuższą metę nie do utrzymania.

Dlaczego?

Obecna architektura sieci – bazująca na układzie klient-serwer – to owoc na poły naszego lenistwa oraz na poły faktu, że w ten sposób najłatwiej na nas zarobić. Jeśli ja posiadam pewne dane czy możliwości obliczeniowe, a ty chcesz z nich skorzystać, musisz mi za to w ten czy inny sposób zapłacić, bo w układzie scentralizowanym łatwo regulować przepływ danych. Sytuacja ta sprawia, że firmy takie jak Google muszą nieustannie rozbudowywać swoje serwerownie. Ale znacznie wydajniej funkcjonują chociażby systemy peer-to-peer (p2p). Zamiast zakładać potężne farmy paneli słonecznych, bardziej opłaca się zamontować po dwa panele na dachu każdego domu. Podobnie wyszukiwarka oparta na p2p mogłaby się okazać znacznie wydajniejsza niż Google. I coraz więcej młodych programistów zdaje sobie sprawę, że taki model zmniejszyłby koszty dystrybucji i pozwolił na lepszą alokację nadwyżek mocy.

Ale sam wspomniałeś, że dobrowolnie pozbawiamy się mocy obliczeniowych.

I jeszcze przez czas będziemy na pewno zmierzać ku modelowi scentralizowanemu. Ale tylko do pewnego momentu. Wystarczy, że pojawi się na przykład kryzys podobny chociażby do energetycznego. Albo że sytuacja przerośnie możliwości Google. Wówczas zrobimy krok wstecz i wrócimy do idei p2p.

Bujamy w chmurach, a ty wraz z kolektywem INTK zajmujesz się dbaniem o to, by wspomniane wcześniej instytucje kultury w ogóle zawitały do internetu?

Doradzamy muzeum czy galeriom, jak realizować ich dotychczasową misję w przestrzeni cyfrowej. Przy czym w pierwszej kolejności chodzi zazwyczaj o rozwianie rozmaitych obaw co do zasad funkcjonowania sieci i konsekwencji czynnego w niej uczestnictwa. Lęk przed zmianą jest o tyle zrozumiały, że podobne w instytucjach główna troska koncentruje się na zachowaniu kontroli, której w ich odczuciu internet zagraża. Niektóre wolałyby zresztą uniknąć cyfryzacji, ale do tego kroku zmusza je sytuacja.

Ponieważ wszyscy inni tak robią?

Jeśli nie chcą utracić swojej pozycji, muszą zatroszczyć się również o publiczność sieciową. Poza tym ich zwierzchnicy coraz częściej pytają nie tylko o wolumen sprzedanych biletów, ale także o liczbę gości zdalnych. Albo nawet polubienia na Facebooku. Główny argument za cyfryzacją zapisany jest jednak w statutach owych instytucji. Skoro ich misją jest przybliżanie sztuki jak największej liczbie osób, to sieć wydaje się tutaj naturalnym sprzymierzeńcem. Ale instytucje kultury mają przeważnie bardzo złożoną strukturę i na każdym jej poziomie napotykamy opór innego rodzaju.

Jedni uważają, że internet jest nie dość dobry dla sztuki wysokiej. Inni obawiają się, że dojdzie do kanibalizacji i odwiedziny zdalne wyprą te realne. I zaczną się redukcje stanowisk. Usiłuję im tłumaczyć, że mówimy o dwóch zupełnie odmiennych doświadczeniach. Przypomnijmy sobie moment, gdy do szkół wprowadzono podręczniki historii sztuki. Czy przejmowaliśmy się tym, że drukowane są na niezbyt jakościowym papierze, a jeszcze do niedawna przeważnie w czerni i bieli? Albo czy ktoś naprawdę wierzył, że ich rozpowszechnianie doprowadzi do spadku liczby odwiedzin w muzeach i galeriach? Przeciwnie. Podobnie jest z internetem. Przecież najczęściej kopiowanym obrazem w sieci jest Mona Lisa.

Ale to do niej ustawiają się kolejki w Luwrze.

Bo im częściej spotykamy się z jej kopiami, przeróbkami czy parodiami, tym większa obsesja na punkcie oryginału. Tym malarstwo czy rzeźba różnią się od filmu, nagrań muzycznych czy książek, które ze swojej natury podlegają reprodukcji, że tutaj mamy do czynienia mamy z konkretnym, unikatowym obiektem. I być może dlatego muzea nie musiały spieszyć się z cyfryzacją. Czuły się bardzo pewnie z tym, co posiadają. Ale dla mnie to absurd, że w XXI wieku nie mogę w sieci obejrzeć wszystkich dzieł Rembrandta uszeregowanych jedno po drugim.

Komu twoim zdaniem udało się pomyślnie wprowadzić do sieci?

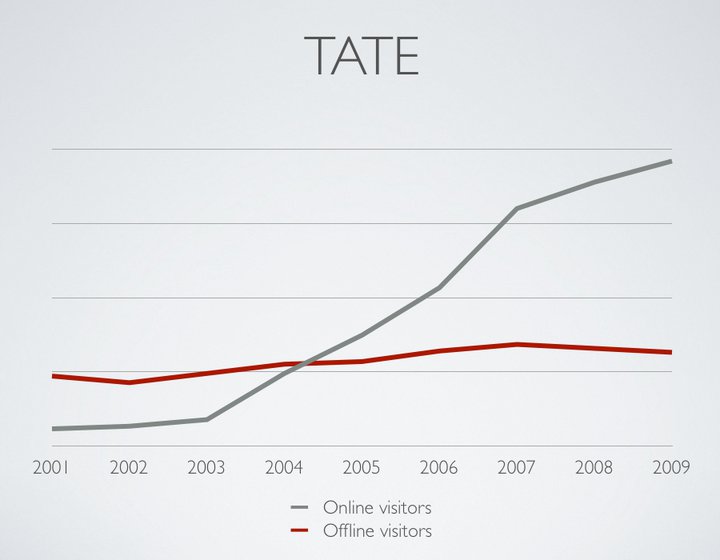

Instytucje w rodzaju londyńskiej Tate Gallery, nowojorskiego Museum of Modern Art czy duńskiego Statens Museum for Kunst błyskawicznie zdały sobie sprawę, że doświadczenie online nabiera coraz większej wagi. Podczas konferencji Kultura 2.0 pokazywałem wykres frekwencji w Tate:

W 1999 roku budynek galerii odwiedzało kilkakrotnie więcej gości niż jej witrynę internetową. W 2004 roku liczby te się zrównały. A w 2008 roku na stronę Tate zaglądało już trzykrotnie więcej osób niż przekraczało jej próg. Co istotne, liczba tych drugich bynajmniej nie spadła, wręcz przeciwnie. Przy czym podobny sukces także potrafi przestraszyć naszych rozmówców. Obawiają się, że nie mają dostatecznych środków finansowych i zasobów ludzkich, by unieść ewentualny sukces.

To znaczy?

Niektórzy przewidują, że jeśli zbyt wiele osób zechce odwiedzić ich muzeum wskutek internetowej kampanii, będą zmuszeni podnieść ceny biletów, aby jakoś okiełznać wybuch zainteresowania. A to prowadziłoby do segregacji społecznej. Bogatsi oglądaliby eksponaty w budynku, a biedniejsi na ekranach. Nie potrafię powiedzieć, na ile prawdopodobny jest taki scenariusz. Zresztą powoli przestajemy dzielić odbiorców na tych wirtualnych i realnych. Mówimy raczej o gościach online oraz on-site, czyli na miejscu. Ci drudzy także podłączeni są do sieci i bez przerwy publikują wrażenia na Facebooku czy Twitterze. Te tłumy w Luwrze ustawiają się przy Mona Lisie między innymi po to, by zrobić sobie zdjęcie – i natychmiast poinformować o tym cały świat.

.

![]()